Das KI-Supercomputerunternehmen Cerebras aus Sunnyvale, Kalifornien, sagt, dass seine nächste Generation von KI-Chips im Wafer-Maßstab die Leistung der vorherigen Generation verdoppeln kann und dabei die gleiche Menge Strom verbraucht. Die Wafer Scale Engine 3 (WSE-3) enthält 4 Billionen Transistoren, eine Steigerung von mehr als 50 % gegenüber der Vorgängergeneration dank des Einsatzes neuerer Chip-Herstellungstechnologie. Das Unternehmen sagt, dass es den WSE-3 in einer neuen Generation von KI-Computern verwenden wird, die derzeit in einem Rechenzentrum in Dallas installiert sind, um einen Supercomputer mit 8 Exaflops (8 Milliarden Milliarden Gleitkommaoperationen pro Sekunde) zu bilden. Unabhängig davon hat Cerebras eine gemeinsame Entwicklungsvereinbarung mit Qualcomm abgeschlossen, die darauf abzielt, den Preis und die Leistung der KI-Inferenz um das Zehnfache zu erhöhen.

Das Unternehmen gibt an, dass der CS-3 neuronale Netzwerkmodelle mit bis zu 24 Billionen Parametern trainieren kann, mehr als das Zehnfache der Größe der derzeit größten LLMs.

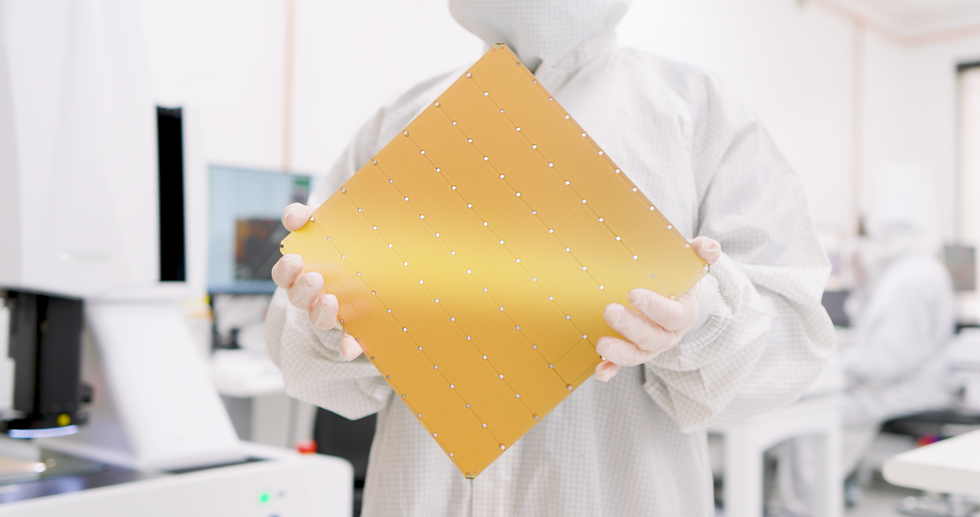

Mit WSE-3 kann Cerebras seinen Anspruch behaupten, den weltweit größten Einzelchip zu produzieren. Es hat eine quadratische Form mit einer Seitenlänge von 21,5 Zentimetern und verwendet für die Herstellung eines Chips fast einen ganzen 300-Millimeter-Wafer aus Silizium. Geräte zur Chipherstellung sind im Allgemeinen auf die Herstellung von Siliziumchips beschränkt, die nicht größer als etwa 800 Quadratmillimeter sind. Chiphersteller haben begonnen, diese Einschränkung durch den Einsatz von 3D-Integration und anderen fortschrittlichen Verpackungstechnologien zu umgehen. 3D-Integration und andere fortschrittliche Verpackungstechnologien zur Kombination mehrerer Dies. Aber selbst in diesen Systemen liegt die Zahl der Transistoren im zweistelligen Milliardenbereich.

Wie immer hat ein so großer Chip überwältigende Superlative.

|

Transistoren |

4 Billionen |

|

Quadratmillimeter Silizium |

46.225 |

|

KI-Kerne |

900.000 |

|

KI-Computing |

125 Petaflops |

|

On-Chip-Speicher |

44 Gigabyte |

|

Speicherbandbreite |

21 Petabyte |

|

Netzwerk-Fabric-Bandbreite |

214 Petabits |

Sie können die Wirkung des Mooreschen Gesetzes in der Abfolge von WSE-Tokens sehen. Das erste, im Jahr 2019 eingeführte Modell wurde mit der 16-Nanometer-Technologie von TSMC hergestellt. Für WSE-2, das 2021 erscheint, wechselte Cerebras zum 7-nm-Prozess von TSMC. WSE-3 wird mit der 5-nm-Technologie des Gießereiriesen gebaut.

Die Anzahl der Transistoren hat sich seit dem ersten Megachip mehr als verdreifacht. Mittlerweile hat sich auch ihre Verwendung geändert. So hat sich beispielsweise die Anzahl der KI-Kerne auf dem Chip deutlich stabilisiert, ebenso wie die Speichermenge und die interne Bandbreite. Dennoch übertraf die Leistungssteigerung bei Gleitkommaoperationen pro Sekunde (Flops) alle anderen Kennzahlen.

CS-3 und das Condor Galaxy 3

Der Computer, der auf dem neuen KI-Chip CS-3 basiert, soll neue Generationen riesiger Sprachmodelle trainieren, die zehnmal größer sind als GPT-4 von OpenAI und Gemini von Google. Das Unternehmen gibt an, dass der CS-3 neuronale Netzwerkmodelle mit einer Größe von bis zu 24 Billionen Parametern trainieren kann, mehr als das Zehnfache der Größe der derzeit größten LLMs, ohne auf eine Reihe von Tricks-Software angewiesen zu sein, die andere Computer benötigen. Laut Cerebras bedeutet dies, dass die Software, die zum Trainieren eines Milliarden-Parameter-Modells auf dem CS-3 benötigt wird, genauso einfach ist wie das Training eines Milliarden-Parameter-Modells auf GPUs.

Bis zu 2.048 Systeme können kombiniert werden, eine Konfiguration, die es ermöglichen würde, das beliebte LLM Llama 70B an einem einzigen Tag von Grund auf zu trainieren. Allerdings sei nichts so Großes in Arbeit, behauptet das Unternehmen. Der erste CS-3-basierte Supercomputer, Condor Galaxy 3 in Dallas, wird aus 64 CS-3 bestehen. Wie bei seinen CS-2-basierten Schwestersystemen ist G42 aus Abu Dhabi Eigentümer des Systems. Zusammen mit Condor Galaxy 1 und 2 ergibt dies ein Array von 16 Exaflops.

„Das bestehende Condor Galaxy-Netzwerk hat einige der branchenweit führenden Open-Source-Modelle mit Zehntausenden Downloads hervorgebracht“, sagte Kiril Evtimov, CTO der G42 Group, in einer Pressemitteilung. „Durch die Verdoppelung der Kapazität auf 16 Exaflops freuen wir uns auf die nächste Innovationswelle, die Condor Galaxy-Supercomputer ermöglichen können.“

Eine Vereinbarung mit Qualcomm

Während Cerebras-Computer für das Training konzipiert sind, sagt Andrew Feldman, CEO von Cerebras, dass die Inferenz, also die Ausführung neuronaler Netzwerkmodelle, die eigentliche Grenze für die Einführung von KI darstellt. Schätzungen von Cerebras zufolge würde die Nutzung von ChatGPT durch jeden Menschen auf dem Planeten eine Billion US-Dollar pro Jahr kosten, ganz zu schweigen von der enormen Menge an Energie aus fossilen Brennstoffen. (Die laufenden Kosten sind proportional zur Größe des neuronalen Netzwerkmodells und der Anzahl der Benutzer.)

Cerebras und Qualcomm haben daher eine Partnerschaft mit dem Ziel geschlossen, die Inferenzkosten um den Faktor 10 zu senken. Cerebras sagt, dass ihre Lösung die Anwendung neuronaler Netzwerktechniken wie Gewichtsdatenkomprimierung und Sparsity (Beschneidung unnötiger Verbindungen) umfassen wird. Die von Cerebras trainierten Netzwerke würden dann effizient auf Qualcomms neuem Inferenzchip, dem AI 100 Ultra, laufen, so das Unternehmen.

Aus den Artikeln auf Ihrer Website

Verwandte Artikel im Internet