In den letzten Monaten haben wir einen gefälschten Robocall von Joe Biden gesehen, der die Wähler in New Hampshire dazu aufforderte, „Ihre Stimme für die Wahlen im November aufzuheben“, und eine gefälschte Befürwortung von Donald Trump durch Taylor Swift. Es ist klar, dass 2024 die erste „KI-Wahl“ in der Geschichte der USA sein wird.

Während viele Befürworter Schutzmaßnahmen gegen den potenziellen Schaden von KI für unsere Demokratie fordern, kündigte Meta (die Muttergesellschaft von Facebook und Instagram) letzten Monat stolz an, dass sie KI-generierte Inhalte kennzeichnen werde, die mit den beliebtesten generativen KI-Tools erstellt wurden. Das Unternehmen sagte, es entwickle „modernste Tools, die in der Lage sind, unsichtbare Markierungen in großem Maßstab zu identifizieren, insbesondere „KI-generierte“ Informationen in den technischen Standards C2PA und IPTC.“

Leider werden Social-Media-Unternehmen mit diesem Ansatz das Problem der Deepfakes in den sozialen Medien in diesem Jahr nicht lösen können. Tatsächlich wird dieser neue Versuch kaum dazu beitragen, das Problem der Verschmutzung des Wahlumfelds durch KI-generiertes Material zu lösen.

Die offensichtlichste Schwäche besteht darin, dass das System von Meta nur funktioniert, wenn böswillige Akteure, die Deepfakes erstellen, Tools verwenden, die bereits Wasserzeichen (d. h. versteckte oder sichtbare Informationen über die Herkunft digitaler Inhalte) in ihren Bildern platzieren. Die meisten unsicheren „Open-Source“-Tools für generative KI erzeugen kein Wasserzeichen. (Wir verwenden den Begriff „unsicher“ und setzen „Open Source“ in Anführungszeichen, um darauf hinzuweisen, dass viele Tools dieser Art nicht den traditionellen Definitionen von Open-Source-Software entsprechen, aber dennoch eine Bedrohung darstellen, weil ihr zugrunde liegender Code oder die Gewichtung ihres Modells veröffentlicht wurden .) Wenn neue Versionen dieser unsicheren Tools mit Wasserzeichen veröffentlicht werden, sind die alten Tools weiterhin verfügbar und in der Lage, Inhalte ohne Wasserzeichen zu produzieren, einschließlich personalisierter und äußerst überzeugender Desinformation und nicht einvernehmlicher Deepfake-Pornografie.

Wir befürchten auch, dass böswillige Akteure das Kennzeichnungssystem von Meta leicht umgehen können, selbst wenn sie die KI-Tools verwenden, von denen Meta sagt, dass sie abgedeckt werden, darunter Produkte von Google, OpenAI, Microsoft, Adobe, Midjourney und Shutterstock. Da es etwa zwei Sekunden dauert, ein Wasserzeichen aus einem Bild zu entfernen, das mit dem aktuellen C2PA-Wasserzeichenstandard dieser Unternehmen erstellt wurde, scheitert Metas Versprechen, KI-generierte Bilder zu kennzeichnen.

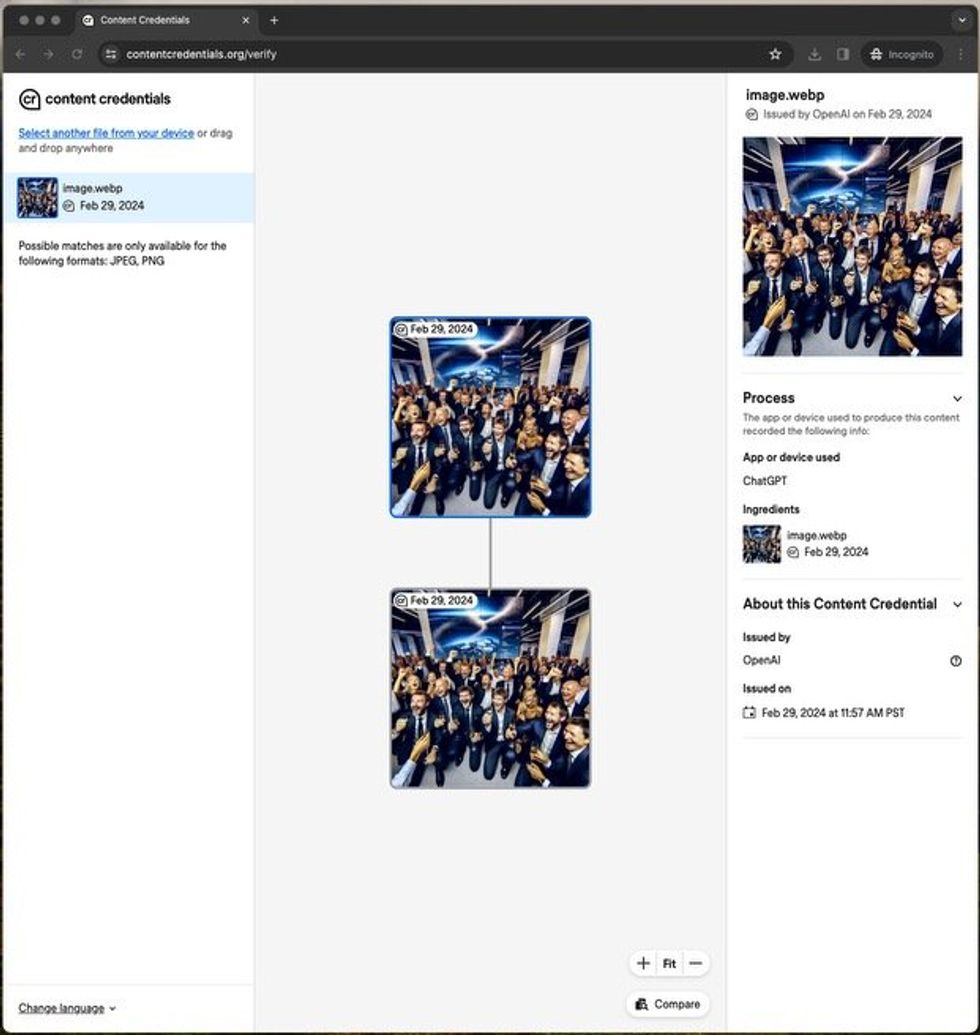

Als die Autoren ein von ihnen erstelltes Bild auf eine Website hochluden, die nach Wasserzeichen sucht, gab die Website korrekt an, dass es sich um ein synthetisches Bild handelte, das von einem OpenAI-Tool generiert wurde. IEEE-Spektrum

Als die Autoren ein von ihnen erstelltes Bild auf eine Website hochluden, die nach Wasserzeichen sucht, gab die Website korrekt an, dass es sich um ein synthetisches Bild handelte, das von einem OpenAI-Tool generiert wurde. IEEE-Spektrum

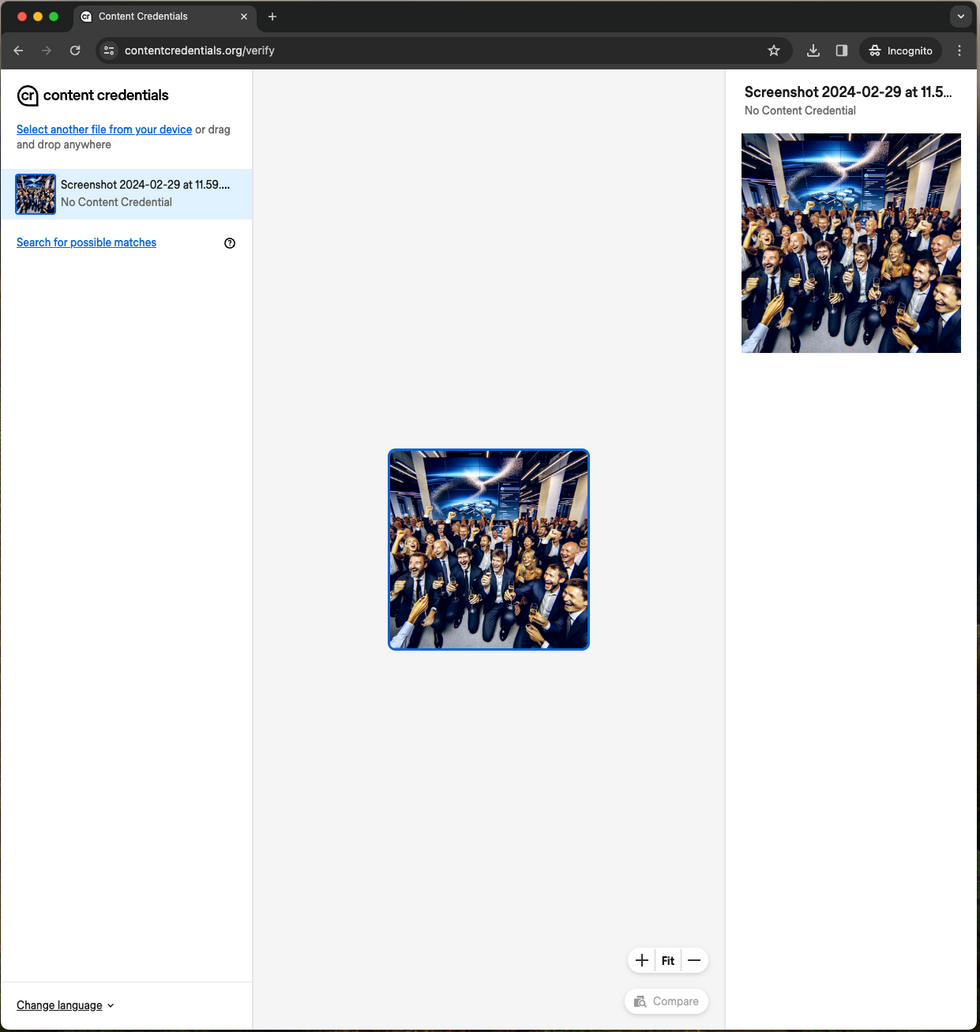

Wir wissen das, weil wir die Wasserzeichen, die Meta angeblich erkennt, problemlos entfernen konnten – und keiner von uns ist Ingenieur. Wir mussten auch keine einzige Codezeile schreiben oder Software installieren.

Zuerst haben wir ein Image mit DALL-E 3 von OpenAI generiert. Um dann zu sehen, ob das Wasserzeichen funktioniert, haben wir das Bild auf die C2PA-Website zur Überprüfung der Anmeldeinformationen für Inhalte hochgeladen. Eine einfache und elegante Benutzeroberfläche zeigte uns, dass dieses Bild tatsächlich mit DALL-E 3 von OpenAI erstellt wurde. Wie haben wir dann das Wasserzeichen entfernt? Indem Sie einen Screenshot machen. Als wir den Screenshot auf dieselbe Verifizierungswebsite hochluden, fanden wir keine Hinweise darauf, dass das Bild von KI erstellt wurde. Der gleiche Vorgang funktionierte, als wir mit dem KI-Bildgenerator von Meta ein Bild erstellten und einen Screenshot davon machten.

Als die Autoren jedoch einen Screenshot des Bildes machten und ihn auf dieselbe Verifizierungsseite hochluden, fand die Seite kein Wasserzeichen und somit keinen Beweis dafür, dass das Bild von der KI erstellt wurde. IEEE-Spektrum

Als die Autoren jedoch einen Screenshot des Bildes machten und ihn auf dieselbe Verifizierungsseite hochluden, fand die Seite kein Wasserzeichen und somit keinen Beweis dafür, dass das Bild von der KI erstellt wurde. IEEE-Spektrum

Gibt es eine bessere Möglichkeit, KI-generierte Inhalte zu identifizieren?

In der Ankündigung von Meta heißt es, dass man „hart daran arbeitet, Klassifikatoren zu entwickeln, die dabei helfen können, KI-generierte Inhalte automatisch zu erkennen, selbst wenn die Inhalte keine unsichtbaren Markierungen enthalten.“ Es ist gut, dass das Unternehmen daran arbeitet, aber bis es gelingt und diese Technologie mit der gesamten Branche geteilt wird, werden wir uns fragen, ob alles, was wir online sehen oder hören, real ist.

Eine unmittelbarere Lösung könnte von der Industrie übernommen werden maximal unauslöschlich Wasserzeichen, also Wasserzeichen, die möglichst schwer zu entfernen sind.

Heutige unvollkommene Wasserzeichen fügen Informationen in der Regel in Form von Metadaten an eine Datei an. Damit unauslöschliche Wasserzeichen eine Verbesserung bewirken, müssen sie Informationen unmerklich in den tatsächlichen Pixeln von Bildern, Audiowellenformen (Google Deepmind behauptet, dies mit seinem proprietären SynthID-Wasserzeichen getan zu haben) oder über leicht modifizierte Worthäufigkeitsmodelle in KI-generiertem Text verbergen. Wir verwenden den Begriff „bis zum Maximum“, um zu erkennen, dass es niemals ein vollkommen unauslöschliches Wasserzeichen geben kann. Es ist nicht nur ein Problem mit Wasserzeichen. Der renommierte Sicherheitsexperte Bruce Schneier stellt fest, dass „Computersicherheit kein Problem ist, das gelöst werden kann …“. Sicherheit war schon immer ein Wettrüsten und wird es auch immer sein.

Metaphorisch gesehen ist es aufschlussreich, über die Sicherheit von Kraftfahrzeugen nachzudenken. Kein Autohersteller hat jemals ein Auto produziert, das nicht unfallsicher war. Dennoch hat das die Regulierungsbehörden nicht davon abgehalten, umfassende Sicherheitsstandards einzuführen, die Sicherheitsgurte, Airbags und Rückfahrkameras in Autos vorschreiben. Wenn wir warten würden, bis die Sicherheitstechnologien perfektioniert sind, bevor wir die Implementierung der besten verfügbaren Optionen fordern, wären wir in vielen Bereichen viel schlechter dran.

Es gibt eine wachsende politische Dynamik zur Bekämpfung von Deepfakes. Fünfzehn der größten KI-Unternehmen – darunter fast alle in diesem Artikel erwähnten – unterzeichneten im vergangenen Jahr die freiwilligen KI-Verpflichtungen des Weißen Hauses, die Zusagen zur „Entwicklung robuster Mechanismen, einschließlich Herkunfts- und/oder Wasserzeichensystemen für Audio- oder visuelle Inhalte“ beinhalteten. und „Tools oder APIs zu entwickeln, um festzustellen, ob ein bestimmter Inhalt mit ihrem System erstellt wurde.“ Leider hat das Weiße Haus keinen Zeitplan für freiwillige Verpflichtungen festgelegt.

Dann, im Oktober, definierte das Weiße Haus in seiner Durchführungsverordnung zu KI KI-Wasserzeichen als „den Vorgang des Einbettens von Informationen, die normalerweise schwer zu entfernen sind, in von KI erstellte Ausgaben, einschließlich Ausgaben wie Fotos, Videos und Audioclips“. . oder Text – zum Zweck der Überprüfung der Echtheit des Produkts oder der Identität oder Merkmale seiner Herkunft, Modifikationen oder seines Transports.

Dann unterzeichnete eine Gruppe von 20 Technologieunternehmen (von denen die Hälfte die Selbstverpflichtungen bereits unterzeichnet hatte) auf der Münchner Sicherheitskonferenz am 16. Februar ein neues „Technologieabkommen zur Bekämpfung des betrügerischen Einsatzes von KI während der Wahlen 2024“. Ohne konkrete Verpflichtungen einzugehen oder einen Zeitplan festzulegen, bietet die Vereinbarung eine vage Absicht, irgendeine Form von Wasserzeichen oder Bemühungen zur Inhaltsherkunft umzusetzen. Obwohl keine Standards festgelegt sind, nennt die Vereinbarung C2PA und SynthID als Beispiele für Technologien, die übernommen werden könnten.

Könnte eine Regulierung helfen?

Wir haben Beispiele für starken Widerstand gegen Deepfakes gesehen. Nach Bidens KI-generierten Robocalls leitete das Justizministerium von New Hampshire in Abstimmung mit staatlichen und bundesstaatlichen Partnern eine Untersuchung ein, darunter eine überparteiliche Task Force bestehend aus allen 50 Generalstaatsanwälten und der Federal Communications Commission. Unterdessen stellte die FCC Anfang Februar klar, dass Anrufe mithilfe sprachgenerierender KI als künstlich betrachtet werden und den geltenden Gesetzen für Robocalls Beschränkungen unterliegen.

Leider gibt es keine Gesetze, die KI-Entwickler oder Social-Media-Unternehmen zum Handeln zwingen könnten. Der Kongress und die Staaten sollten von allen generativen KI-Produkten verlangen, dass sie mithilfe modernster Technologie so weit wie möglich unauslöschliche Wasserzeichen in ihre Bild-, Audio-, Video- und Textinhalte einbetten. Sie sollten auch die Risiken ungesicherter „Open-Source“-Systeme berücksichtigen, deren Wasserzeichenfunktion möglicherweise deaktiviert ist oder zum Entfernen von Wasserzeichen aus anderen Inhalten verwendet wird. Darüber hinaus sollte jedes Unternehmen, das ein generatives KI-Tool herstellt, dazu ermutigt werden, einen Detektor auf den Markt zu bringen, der alle von ihm produzierten Inhalte so genau wie möglich identifizieren kann. Dieser Vorschlag sollte nicht umstritten sein, da seine Grundzüge bereits von den Unterzeichnern der Selbstverpflichtungen und der jüngsten Wahlvereinbarung angenommen wurden.

Normungsgremien wie C2PA, das National Institute of Standards and Technology und die International Organization for Standardization sollten ebenfalls schneller voranschreiten, um einen Konsens zu erzielen und so weit wie möglich Standards für unauslöschliche Wasserzeichen und Inhaltskennzeichnung zu veröffentlichen. , im Vorgriff auf Gesetze, die diese Technologien erfordern . Es wird auch erwartet, dass Google als neues Mitglied des C2PA-Lenkungsausschusses seine scheinbar beste SynthID-Wasserzeichentechnologie schnell allen Mitgliedern zum Testen zugänglich macht.

Fehlinformationen und Wählertäuschung sind bei Wahlen nichts Neues. Aber KI beschleunigt bestehende Bedrohungen für unsere ohnehin fragile Demokratie. Der Kongress muss auch darüber nachdenken, welche Schritte er unternehmen kann, um unsere Wahlen im Allgemeinen vor denen zu schützen, die sie untergraben wollen. Dazu sollten einige grundlegende Maßnahmen gehören, wie etwa die Verabschiedung des Deceptive Practices and Voter Intimidation Act, der es illegal machen würde, Wähler wissentlich über Zeit, Ort und Art der Wahlen anzulügen, um sie im Vorfeld von der Stimmabgabe abzuhalten zur Wahl. eine Bundestagswahl.

Angesichts der jüngsten Erschütterungen hat der Kongress eine umfassende Demokratiereform nur äußerst langsam in Angriff genommen. Die potenzielle Verstärkung dieser Schocks durch KI-Missbrauch sollte ausreichen, um den Gesetzgeber endlich zum Handeln zu bewegen.

Aus den Artikeln auf Ihrer Website

Verwandte Artikel im Internet