„Was brauche ich, um bei kaltem Wetter Golf zu spielen?“ »

„Was sind die Unterschiede zwischen Trailschuhen und Laufschuhen? »

„Was sind die besten Dinosaurierspielzeuge für einen Fünfjährigen?“ »

Hier sind einige der offenen Fragen, die Kunden einem hilfsbereiten Verkäufer in einem Ladengeschäft stellen könnten. Doch wie können Kunden beim Online-Einkauf Antworten auf ähnliche Fragen erhalten?

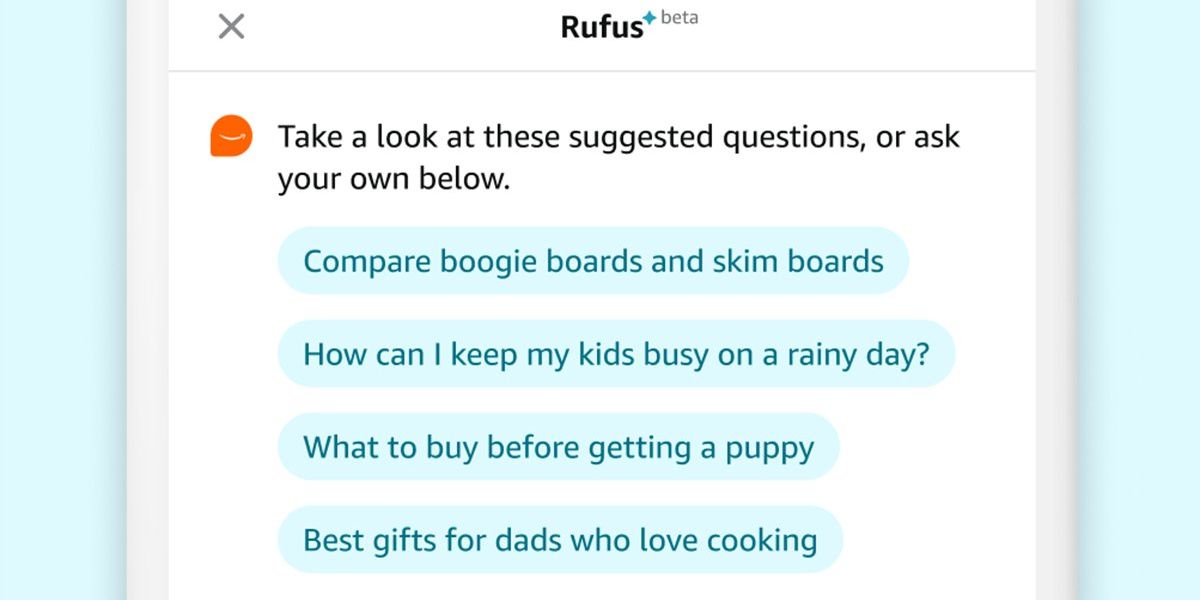

Die Antwort von Amazon ist Rufus, ein Verkaufsassistent mit generativer KI. Rufus hilft Amazon-Kunden, fundiertere Kaufentscheidungen zu treffen, indem es in der Amazon-App eine Vielzahl von Fragen beantwortet. Benutzer können Produktdetails abrufen, Optionen vergleichen und Produktempfehlungen erhalten.

Ich leite das Team aus Wissenschaftlern und Ingenieuren, die das Large Language Model (LLM) entwickelt haben, das Rufus antreibt. Um einen nützlichen dialogorientierten Einkaufsassistenten zu entwickeln, haben wir innovative Techniken in verschiedenen Aspekten der generativen KI eingesetzt. Wir haben ein maßgeschneidertes LLM entwickelt, das auf das Einkaufen spezialisiert ist. verwendete Retrieval-Augmented-Generierung mit einer Vielzahl neuer Beweisquellen; nutzte Verstärkungslernen, um die Reaktionen zu verbessern; macht Fortschritte im Hochleistungsrechnen, um die Inferenzeffizienz zu verbessern und die Latenz zu reduzieren; und eine neue Streaming-Architektur implementiert, um Käufern ihre Antworten schneller zukommen zu lassen.

Wie Rufus Antworten bekommt

Die meisten LLMs werden zunächst anhand eines großen Datensatzes trainiert, der das Gesamtwissen und die Fähigkeiten des Modells beleuchtet, und werden dann für eine bestimmte Domäne angepasst. Für Rufus würde das nicht funktionieren, da unser Ziel darin bestand, ihn von Anfang an im Kauf von Daten zu schulen: zunächst einmal im gesamten Amazon-Katalog sowie in Kundenrezensionen und Informationen aus Fragebeiträgen und Community-Antworten. Deshalb haben unsere Wissenschaftler ein benutzerdefiniertes LLM erstellt, das auf diesen Datenquellen sowie öffentlichen Informationen im Internet trainiert wurde.

Um jedoch auf die vielfältigen Fragen vorbereitet zu sein, die möglicherweise gestellt werden könnten, muss Rufus in die Lage versetzt werden, über seine anfänglichen Trainingsdaten hinauszugehen und neue Erkenntnisse einzubringen. Um beispielsweise die Frage zu beantworten: „Ist diese Pfanne spülmaschinenfest?“ » Das LLM analysiert zunächst die Frage und bestimmt dann, welche Abrufquellen ihm bei der Generierung der Antwort helfen.

Unser LLM nutzt Retrieval Augmented Generation (RAG), um Informationen aus Quellen zu extrahieren, die als zuverlässig gelten, wie z. B. dem Produktkatalog, Kundenrezensionen und Community-Q&A-Beiträgen; Es kann auch relevante Amazon Stores-APIs aufrufen. Unser RAG-System ist äußerst komplex, sowohl aufgrund der Vielfalt der verwendeten Datenquellen als auch der unterschiedlichen Relevanz jeder einzelnen, je nach Fragestellung.

Jedes LLM und jeder Einsatz generativer KI ist in Arbeit. Damit sich Rufus im Laufe der Zeit verbessert, muss er lernen, welche Reaktionen nützlich sind und welche verbessert werden können. Kunden sind die beste Quelle für diese Informationen. Amazon ermutigt Kunden, Rufus Feedback zu geben und dem Modell mitzuteilen, ob ihnen die Antwort gefallen hat oder nicht. Diese Antworten werden in einem verstärkenden Lernprozess verwendet. Im Laufe der Zeit lernt Rufus aus dem Feedback der Kunden und verbessert seine Antworten.

Spezielle Chips und Handhabungstechniken für Rufus

Rufus muss in der Lage sein, ohne spürbare Verzögerung mit Millionen von Kunden gleichzeitig zu interagieren. Dies stellt eine besondere Herausforderung dar, da generative KI-Anwendungen rechenintensiv sind, insbesondere auf der Ebene von Amazon.

Um die Antwortgenerierungszeiten zu minimieren und gleichzeitig die Anzahl der Antworten zu maximieren, die unser System verarbeiten kann, haben wir uns an die speziellen KI-Chips von Amazon, Trainium und Inferentia, gewandt, die in die zentralen Webdienste (AWS) von Amazon integriert sind. Wir haben mit AWS an Optimierungen zusammengearbeitet, die die Effizienz der Modellinferenz verbessern und die dann allen AWS-Kunden zur Verfügung gestellt wurden.

Standardmethoden zur stapelweisen Verarbeitung von Benutzeranfragen führen jedoch zu Latenz- und Durchsatzproblemen, da es schwierig ist vorherzusagen, wie viele Token (in diesem Fall Texteinheiten) ein LLM beim Verfassen jeder Antwort generieren wird. Unsere Wissenschaftler haben mit AWS zusammengearbeitet, um Rufus die Verwendung von Continuous Batching zu ermöglichen, einer neuen LLM-Technik, die es dem Modell ermöglicht, mit der Bearbeitung neuer Abfragen zu beginnen, sobald die erste Abfrage im Batch abgeschlossen ist, anstatt auf das Ende aller Anfragen in einem Batch zu warten. Diese Technik verbessert die Recheneffizienz von KI-Chips und ermöglicht es Käufern, ihre Antworten schnell zu erhalten.

Wir möchten, dass Rufus auf jede Frage die relevanteste und hilfreichste Antwort gibt. Manchmal bedeutet dies eine lange Textantwort, aber manchmal ist es ein kurzer Text oder ein anklickbarer Link zum Navigieren im Shop. Und wir mussten sicherstellen, dass die präsentierten Informationen einem logischen Ablauf folgten. Wenn wir die Elemente nicht richtig gruppieren und formatieren, kann es sein, dass wir eine verwirrende Antwort erhalten, die für den Kunden von geringem Nutzen ist.

Deshalb nutzt Rufus eine fortschrittliche Streaming-Architektur, um Antworten zu liefern. Kunden müssen nicht auf die vollständige Generierung einer langen Antwort warten. Stattdessen erhalten sie den ersten Teil der Antwort, während der Rest generiert wird. Rufus füllt die Streaming-Antwort mit den richtigen Daten (ein Prozess namens Hydratation), indem er Abfragen an interne Systeme stellt. Zusätzlich zum Generieren von Antwortinhalten generiert es auch Formatierungsanweisungen, die angeben, wie verschiedene Antwortelemente angezeigt werden sollen.

Obwohl Amazon seit mehr als 25 Jahren KI einsetzt, um das Kundenerlebnis zu verbessern, stellt generative KI etwas Neues und Transformierendes dar. Wir sind stolz auf Rufus und die neuen Funktionen, die es unseren Kunden bietet.

Aus den Artikeln auf Ihrer Website

Verwandte Artikel im Internet