Heute stellte das Unternehmen auf Nvidias Entwicklerkonferenz GTC 2024 seine nächste GPU vor, die B200. Der B200 ist in der Lage, eine viermal bessere Trainingsleistung, eine bis zu 30-mal bessere Inferenzleistung und eine bis zu 25-mal bessere Energieeffizienz als sein Vorgänger, die Hopper H100-GPU, zu liefern. Basierend auf der neuen Blackwell-Architektur kann die GPU mit den Grace-Prozessoren des Unternehmens kombiniert werden, um eine neue Generation von DGX-SuperPOD-Computern zu bilden, die bis zu 11,5 Billionen Gleitkommaoperationen (Exaflops) KI-Berechnungen unter Verwendung einer neuen Zahl mit niedriger Präzision durchführen können. Format.

„Blackwell ist eine neue Klasse von KI-Superchips“, sagte Ian Buck, Vizepräsident für High-Performance Computing und Hyperscale bei Nvidia. Nvidia benannte die GPU-Architektur nach dem Mathematiker David Harold Blackwell, dem ersten schwarzen Mitglied der National Academy of Sciences der Vereinigten Staaten.

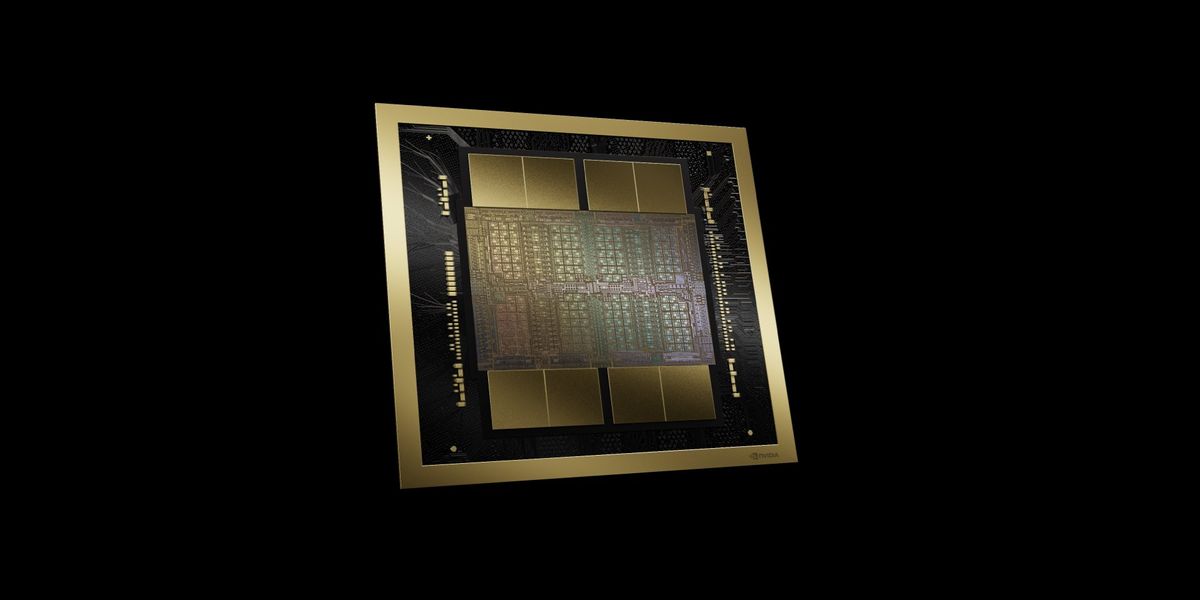

Der B200 besteht aus einem etwa 1.600 Quadratmillimeter großen Prozessor auf zwei Siliziumchips, die im selben Gehäuse über eine Verbindung mit 10 Terabyte pro Sekunde verbunden sind, sodass sie funktionieren, als wären sie ein einziger Chip mit 208 Milliarden Transistoren. Diese Siliziumwafer werden mit der N4P-Chiptechnologie von TSMC hergestellt, die eine Leistungssteigerung von 6 % gegenüber der N4-Technologie bietet, die zur Herstellung von GPUs mit Hopper-Architektur wie dem H100 verwendet wird.

Wie die Hopper-Chips ist auch der B200 von Speicher mit hoher Bandbreite umgeben, was für die Reduzierung der Latenz und des Stromverbrauchs großer KI-Modelle immer wichtiger wird. Der Speicher des B200 ist die neueste Variante, HBM3e, und beträgt insgesamt 192 GB (im Vergleich zu 141 GB beim Hopper-Chip der zweiten Generation, H200). Darüber hinaus wird die Speicherbandbreite von 4,8 TB/s beim H200 auf 8 Terabyte pro Sekunde erhöht.

Kleinere Zahlen, schnellere Chips

Die Chip-Herstellungstechnologie hat einen Teil zur Entwicklung von Blackwell beigetragen, aber es ist die Art und Weise, wie die GPU mit den Transistoren arbeitet, die den wirklichen Unterschied ausmacht. Bill Dally, Chefwissenschaftler von Nvidia, erläuterte Informatikern letztes Jahr auf der IEEE Hot Chips den KI-Erfolg von Nvidia und sagte, der Großteil sei auf die Verwendung immer weniger Bits zur Darstellung von Zahlen in KI-Berechnungen zurückzuführen. Blackwell setzt diesen Trend fort.

Die vorherige Architektur, Hopper, war die erste Instanz dessen, was Nvidia Transformer Engine nennt. Hierbei handelt es sich um ein System, das jede Schicht eines neuronalen Netzwerks untersucht und bestimmt, ob sie mit Zahlen mit geringerer Genauigkeit berechnet werden kann. Insbesondere kann Hopper Gleitkommazahlenformate mit einer Größe von nur 8 Bit verwenden. Kleinere Zahlen lassen sich schneller und energieeffizienter berechnen, erfordern weniger Speicher und Speicherbandbreite und die zur Durchführung der Berechnungen erforderliche Logik verbraucht weniger Silizium.

„Mit Blackwell sind wir noch einen Schritt weiter gegangen“, sagt Buck. Die neue Architektur verfügt über Einheiten, die Matrixberechnungen mit nur 4 Bit breiten Gleitkommazahlen durchführen. Darüber hinaus kann es beschließen, sie auf Teilen jeder neuronalen Netzwerkschicht einzusetzen, nicht nur auf ganzen Schichten wie Hopper. „Dieses Maß an Feingranularität zu erreichen, ist an sich schon ein Wunder“, sagt Buck.

NVLink und andere Funktionen

Zu den weiteren Architekturinformationen, die Nvidia über Blackwell preisgibt, gehört die Integration einer „Engine“, die sich der Zuverlässigkeit, Verfügbarkeit und Wartungsfreundlichkeit der GPU widmet. Laut Nvidia nutzt es ein KI-basiertes System, um Diagnosen durchzuführen und Zuverlässigkeitsprobleme vorherzusagen, mit dem Ziel, die Zeit zu verlängern und dazu beizutragen, dass riesige KI-Systeme wochenlang ununterbrochen laufen, ein Zeitraum, der oft für die Bildung großer Sprachmodelle erforderlich ist.

Nvidia hat außerdem Systeme integriert, die dabei helfen, KI-Modelle zu sichern und Daten zu dekomprimieren, um Datenbankabfragen und Datenanalysen zu beschleunigen.

Schließlich integriert Blackwell Nvidias Computing-Interconnect-Technologie der fünften Generation, NVLink, die nun bidirektional 1,8 Terabyte pro Sekunde zwischen GPUs liefert und eine Hochgeschwindigkeitskommunikation zwischen bis zu 576 GPUs ermöglicht. Die Hopper-Version von NVLink konnte nur die Hälfte dieser Bandbreite erreichen.

SuperPOD und andere Computer

Die Bandbreite von NVLink ist entscheidend für den Aufbau der Großcomputer von Blackwell, die in der Lage sind, neuronale Netzwerkmodelle mit Milliarden von Parametern zu analysieren.

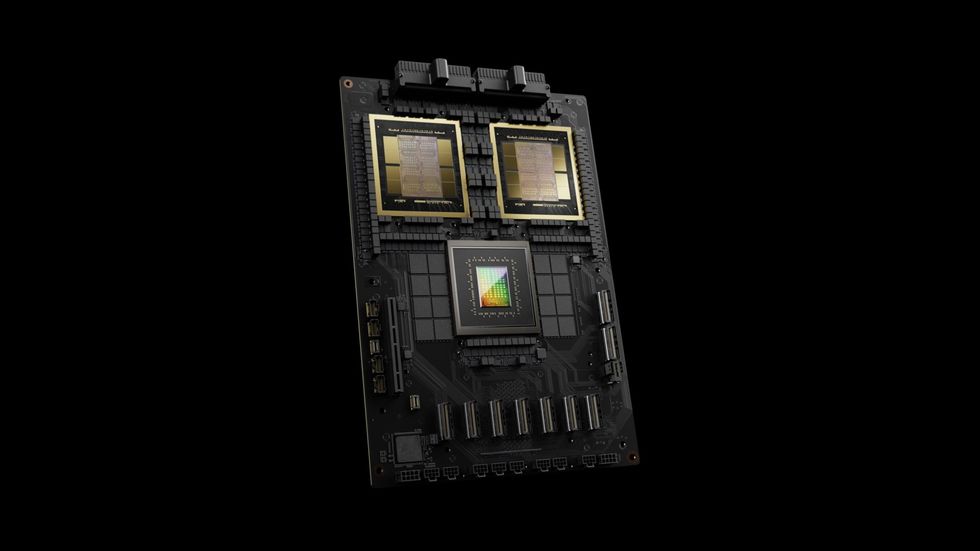

Die Basis-Recheneinheit heißt DGX GB200. Jeder von ihnen enthält 36 GB200-Superchips. Hierbei handelt es sich um Module, die einen Grace-Prozessor und zwei Blackwell-GPUs umfassen, die alle über NVLink miteinander verbunden sind.

Der Grace-Blackwell-Superchip besteht aus zwei Blackwell-GPUs und einer Grace-CPU im selben Modul.Nvidia

Der Grace-Blackwell-Superchip besteht aus zwei Blackwell-GPUs und einer Grace-CPU im selben Modul.Nvidia

Acht DGX GB200 können über NVLINK weiter verbunden werden, um einen 576-GPU-Supercomputer namens DGX SuperPOD zu bilden. Nvidia behauptet, dass ein solcher Computer mit 4-Bit-Präzisionsberechnungen 11,5 Exaflops ausführen kann. Mit der Quantum Infiniband-Netzwerktechnologie des Unternehmens sind Systeme mit Zehntausenden GPUs möglich.

Das Unternehmen geht davon aus, dass SuperPODs und andere Nvidia-Computer noch in diesem Jahr verfügbar sein werden.