Nvidias unverzichtbarer H100-KI-Chip hat das Unternehmen zu einem Multimilliarden-Dollar-Unternehmen gemacht, das vielleicht mehr wert ist als Alphabet und Amazon, und seine Konkurrenten versuchen, aufzuholen. Aber vielleicht ist Nvidia dabei, seinen Vorsprung auszubauen – mit der neuen Blackwell B200 GPU und dem GB200 „Superchip“.

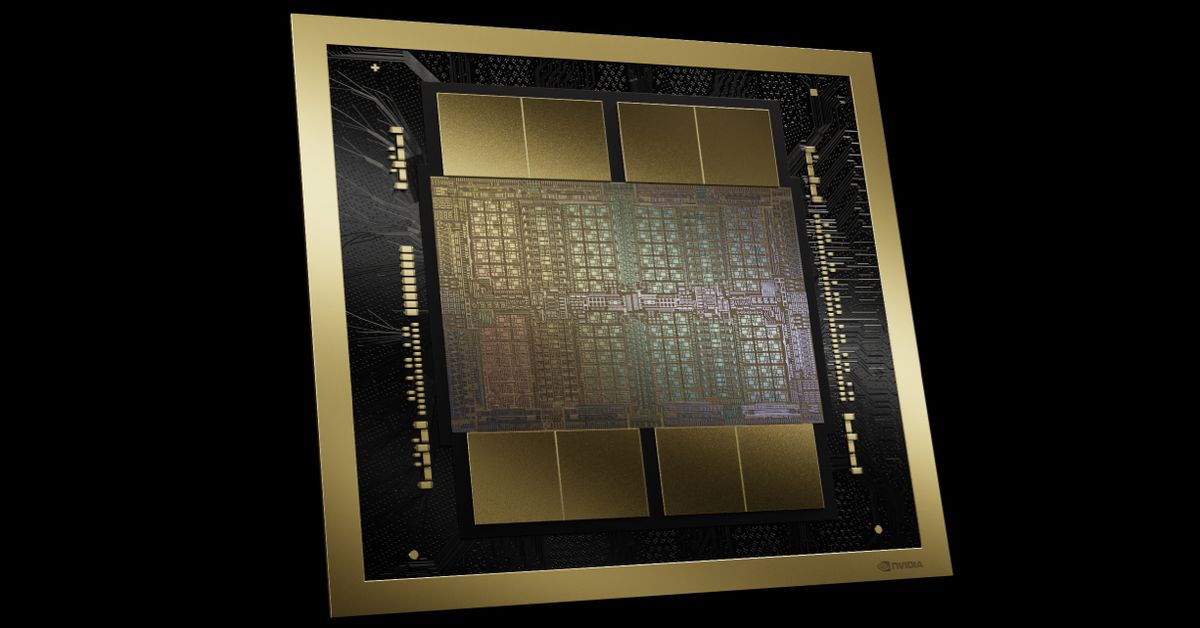

Nvidia behauptet, dass die neue B200-GPU bis zu 20 bietet Petaflops von FP4-Leistung aus seinen 208 Milliarden Transistoren und dass ein GB200, der zwei dieser GPUs mit einer einzigen Grace-CPU kombiniert, eine 30-mal bessere Leistung für LLM-Inferenz-Workloads liefern kann und gleichzeitig möglicherweise viel effizienter ist. Laut Nvidia „senkt es die Kosten und den Stromverbrauch um das bis zu 25-fache“ im Vergleich zu einem H100.

Das Training eines Modells mit 1,8 Billionen Parametern hätte bisher 8.000 GPUs und 15 Megawatt Leistung erfordert, behauptet Nvidia. Nun sagt der CEO von Nvidia, dass 2.000 Blackwell-GPUs dies schaffen und dabei nur 4 Megawatt verbrauchen.

Bei einem GPT-3-LLM-Benchmark mit 175 Milliarden Parametern behauptet Nvidia, dass der GB200 eine etwas bescheidenere Leistung aufweist, siebenmal besser als ein H100, und Nvidia behauptet, dass er die vierfache Trainingsgeschwindigkeit liefert.

Nvidia sagte Reportern, dass eine der wichtigsten Verbesserungen eine Transformer-Engine der zweiten Generation sei, die die Berechnung, Bandbreite und Modellgröße verdoppelt, indem sie für jedes Neuron vier statt acht Bits verwendet (daher die 20 Petaflops von FP4, die ich zuvor erwähnt habe). Ein zweiter wesentlicher Unterschied tritt nur auf, wenn Sie eine große Anzahl dieser GPUs anschließen: einen NVLink-Switch der nächsten Generation, der es 576 GPUs ermöglicht, miteinander zu kommunizieren, mit einer bidirektionalen Bandbreite von 1,8 Terabyte pro Sekunde.

Dafür musste Nvidia einen völlig neuen Netzwerk-Switching-Chip bauen, einen mit 50 Milliarden Transistoren und einigen eigenen Onboard-Rechnern: 3,6 Teraflops FP8, sagt Nvidia.

Zuvor verbrachte ein Cluster aus nur 16 GPUs laut Nvidia 60 % seiner Zeit mit der Kommunikation untereinander und nur 40 % mit der Datenverarbeitung.

Nvidia rechnet natürlich damit, dass Unternehmen große Mengen dieser GPUs kaufen und sie in größeren Supercomputer-fähigen Designs verpacken, wie dem GB200 NVL72, der 36 CPUs und 72 GPUs in einem einzigen flüssigkeitsgekühlten Rack für insgesamt 720 Petaflops KI unterbringt Trainingsleistung oder 1.440 Petaflops (also 1,4 Exaflops) der Schlussfolgerung. Es enthält fast drei Kilometer Kabel mit 5.000 Einzelkabeln.

Jedes Fach im Rack enthält entweder zwei GB200-Chips oder zwei NVLink-Switches, wobei 18 der ersteren und neun der letzteren pro Rack vorhanden sind. Insgesamt behauptet Nvidia, dass eines dieser Racks ein Modell mit 27 Billionen Parametern unterstützen kann. Gerüchten zufolge handelt es sich bei GPT-4 um ein Modell mit etwa 1,7 Billionen Parametern.

Das Unternehmen sagt, dass Amazon, Google, Microsoft und Oracle bereits planen, die NVL72-Racks in ihren Cloud-Service-Angeboten anzubieten, obwohl unklar ist, wie viele sie kaufen.

Und natürlich bietet Nvidia Unternehmen auch gerne den Rest der Lösung an. Wir stellen den DGX Superpod für DGX GB200 vor, der acht Systeme in einem für insgesamt 288 CPUs, 576 GPUs, 240 TB Speicher und 11,5 Exaflops FP4-Rechenleistung vereint.

Nvidia gibt an, dass seine Systeme mit seinem neuen Quantum-X800 InfiniBand (für bis zu 144 Verbindungen) oder Ethernet Spectrum-X800 (für bis zu 64 Verbindungen) auf Zehntausende GB200-Superchips skaliert werden können, die mit einem 800-Gbit/s-Netzwerk verbunden sind.